|

|

Дублированный контент. Распространенные примеры

С праздником Великой Пасхи вас, дорогие читатели Блога SEO сектанта!

С праздником Великой Пасхи вас, дорогие читатели Блога SEO сектанта!

Пришло время закончить мою серию статей о дублированном контенте, и случится это сегодня. Я расскажу о самых распространенных примерах дублей и о том, как с ними лучше бороться. Если у вас есть вопросы, дополнения – буду рада ответить на все в комментариях.

Предыдущие статьи в этой серии:

Ну вот а сейчас о примерах!

Зеркала сайта

www.site.ru site.ru

Обычно эта проблема решается с помощью 301 редиректа. Главное зеркало также указывается в Вебмастере.

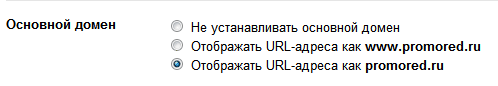

Для Гугла: Вебмастер> Конфигурация сайта> Настройки и указываем главное зеркало. Причем для этого оба зеркала должны быть добавлены в ваш Вебмастер.

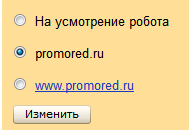

Для Яндекса: заходим в Вебмастер> Настройка индексирования > Главное зеркало.

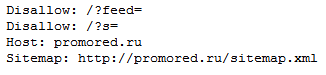

Плюс для Яндекса в файле robots.txt указываем host:главное зеркало.

Главная страница доступна с /index.html (php, htm…)

Я такое встречаю очень часто. Чаще всего такой адрес появляется, когда человек переходит на главную страницу, кликнув на логотип. 301 редирект справится и с этим. В дополнение к нему нужно убрать с сайта все ссылки на страницу с /index.html (php, html…), и в первую очередь – с логотипа.

«/» в конце адреса страницы.

Это больше техническая проблема. Раньше такие страницы:

www.site.ru/services www.site.ru/services/

считались разными. Но теперь в большинстве случаев ПС успешно справляются с такими дубликатами. Даже браузеры их склеивают, обычно добавляя на конце адреса слэш. Однако, я как-то наблюдала такую ситуацию: то, как в адресной строке браузера будет отображаться адрес сайта, зависит от того, как в первый раз его ввели. То есть, если мы зашли на сайт введя site.ru, а в следующий раз в конце добавляем «/» – нас переадресовывает на первоначальную страницу без слэша, и наоборот.

Сервисные адреса

Выглядят они примерно так:

80342.site.web.hosting-test.net site.com.pollux.neolocation.net

Вот очередной полный дубликат. Это решается путем добавления сайта в Вебмастер. После первой индексации системный адрес из выдачи пропадает.

Большие и маленькие буквы в адресе страницы

site.ru/search-engine-optimisation site.ru/Search-Engine-Optimisation

Как ни странно, но эти страницы тоже воспринимаются Гуглом как разные. Решение – 301 редирект.

Страницы для печати

Их можно полностью закрыть от индексации в robots.txt или заключить в NOINDEX, NOFOLLOW.

Безопасные (https) страницы

https://site.ru/ https://site.ru/

Если такие страницы оказались в индексе – значит, скорее всего, на них ссылаются другие страницы. Их нужно найти (это можно сделать в каком-нибудь сервисе проверки обратных ссылок, лучше всего – с OSE сеомоза, т.к. он показывает и внешние, и внутренние входящие ссылки).

Избавиться от дубликатов можно с помощью 301 редиректа, robots.txt или rel=canonical, однако делать это нужно очень осторожно. В идеале, безопасными должны оставаться только такие страницы, как «Вход», «Корзина», «Оплата» и т.д.

Параметры сессии в адресе страницы

www.site.ru www.site.ru/?session=123456

Если ничего не предпринимать, то такие страницы будут попадать в индекс и создавать огромную кучу дубликатов.

Лучшее решение в этой ситуации – отказаться от таких параметров. Но если они все-таки очень уж нужны, то можно использовать rel=canonical. Также можно запретить их индексацию в Вебмастере Гугла в инструменте настройки параметров URL (Вебмастер> Конфигурация сайта > Настройка параметоров URL). Но лучше все же не использовать их.

Разные пути к одной странице

www.site.com/personalised-gifts/for-her/personalised-mug/ www.site.com/personalised-gifts/personalised-mug/

В идеале, для каждой страницы должен быть только один адрес, независимо от пути к ней. Но в данном случае лучшим решением будет канонизация одной из страниц с помощью rel=canonical. Если такое на сайте встречается очень часто, стоит пересмотреть его структуру.

Архивы, категории, тэги

Чаще всего такие дубликаты встречаются на блогах, где один пост может быть доступен по разным адресам:

promored.ru/useful-mozilla-add-ons/ promored.ru/tag/mozilla-add-ons/ promored.ru/category/mozilla-add-ons/ promored.ru/2012/02/

В этом случае лучше всего, во-первых, в каждой записи использовать тег <!—more–>, чтобы она транслировалась полностью только по своему адресу, а во-вторых, закрыть от индексации тэги, категории и архивы в robots.txt и/или с помощью meta-robots.

Страницы поиска и сортировки

www.site.ru/search.htm?keywords=podarki www.site.ru/podarki.htm?pagesize=large www.site.ru/podarki.htm?sortby=price|asc www.site.ru/podarki.htm?pagesize=large&sortby=price|desc

Все эти страницы – частичные дубликаты, с которыми нужно бороться. Но сначала их нужно вычислить.

Обычно, у таких страниц есть что-то общее в адресе, это и поможет узнать, сколько таких страниц попало в индекс (для примера возьмем “sortby”). Вводим:

inurl:sortby site:site.ru

и любуемся.

Чтобы избавиться от страниц сортировок и поиска, можно запретить их в robots.txt (особенно, если они еще не попали в индекс) и/или использовать rel=canonical, указав страницу, которая будет ранжироваться.

Тестовые страницы

Бывает, когда вебмастера тестируют новый дизайн или различный контент на страницах, тестовые страницы могут попасть в индекс, если их изначально никто не закрыл. Они могут иметь такой вид:

www.site.ru www.site.ru/index-b www.site.ru/index-c

В таком случае еще до создание тестовых страниц, нужно запретить их в robots.txt. Если этого сделано не было и страницы все же попали в индекс – поможет rel=canonical.

Кстати, есть такой интересный сайт, который помогает тестировать дизайн страниц – https://optimizely.appspot.com/. Поскольку тестирование будет происходить на стороннем ресурсе – создание дублей не грозит.

Страницы с нумерацией

Очень большую проблему вызывают страницы с нумерацией: например, на сайте онлайн магазина в одной категории много товаров, они разбиты на несколько страниц, на которых отличаться будут только сами товары, а все остальное, будет одинаковым.

www.site.ru/podarki-dly-nee.htm www.site.ru/podarki-dly-nee.htm?page=3 www.site.ru/podarki-dly-nee.htm?page=22

Тут несколько вариантов:

- Создать страницу со всеми товарами и поставить rel=canonical, указывающий на нее, на все страницы с нумерацией;

- Использовать rel=prev и rel=next;

- Использовать для всех, кроме первой страницы нумерации meta robots=NOINDEX, FOLLOW

.

Практически одинаковые товары

Это частичные дубликаты :например, страницы для одинаковых продуктов разных цветов. Описание, название – все одинаковое, отличаться будет лишь картинка

www.site.ru/cat-toy-red www.site.ru/cat-toy-blue

Тут можно либо сделать страницы более уникальными, написав интересный текст для каждой из них. Но если таких страниц много – это достаточно трудозатратно. Поэтому можно канонизировать только одну страницу из частичных дубликатов.

Синдикация контента

Синдикация – это распространение контента на другие сайты с разрешения источника (обычно, вставляется ссылка на источник).

Когда дело касается внешнего дублированного контента, Гугл распознает первоисточник хорошо, но не всегда правильно. Решением в этом случае может быть кросс-доменный rel=canonical или метатеги атрибута источника, которые укажут, на каком сайте ранжировать данный текст.

Кража контента

Это происходит часто, и ничего с этим не поделаешь. Некоторые видят в этом плюсы и легкую возможность получения обратных ссылок. Предположим, у нас есть пост, который перелинкован с другими нашими постами. При воровстве некоторые люди не удосуживаются даже удалить эти ссылки и, более того, оставляют их dofollow. Это, конечно, спорный метод получения обратных ссылок, однако хорошее утешение, если договориться с ворами так и не удалось.

Некачественный контент

Если текст на страницах не одинаковый, но очень похожий, то Google вряд ли высоко оценит ваш сайт. Еще хуже – если на страницах больше рекламы, чем текста. Это, конечно, не дубликаты, но если большая часть вашего сайта наполнена некачественным контентом – стоит пересмотреть свою стратегию.

Вот и все. Ищите дубликаты, боритесь с ними и не создавайте новые! И помните, Панда уже близко, так что не привлекайте ее внимание, чтобы и вам от не досталось от этого зверя. И, конечно, подписывайтесь на обновления!

Всем удачного дня. До встречи на promoRED!

Любые страница с приставками в виде вопроса ? можно вот так отсекать:

Disallow: /*?

Disallow: /*?*

Disallow: /?*

PCGAMER2005, тут достаточно только Disallow: /*?*, т.к. значок * означает “любые символы”, точно также как и пустое место. Соответственно, все приведенные вами директивы по сути являются разными вариациями одного запрета.

Согласен, я привел все вместе для примера.

А вообще, я к тому, что это порой намного проще, чем пытаться использовать тег rel=cannonical

который, к сожалению, не ко всем страницам есть возможность добавить

PCGAMER2005 недавно опубликовал(а)…KostyGuberkan: Все правильно сделал https://t.co/D42WTkQF

Надо внимательно изучить статью и проверить свой сайт на вшивость

Mazaykina недавно опубликовал(а)…Первый Международный фестиваль "Планета Детей" в Италии с 30.05 по06.06 12

Как, оказывается, я много не знаю в этой теме. Буду раскуривать эту тему по Вашим постам, но чуть позже. А сейчас – будьте уверены, у Вас появился еще один подписчик

ZeroXor, очень рада! Заходите